[ad_1]

A poco más de un año del escándalo de DeepNude, una aplicación similar utiliza la inteligencia artificial para crear imágenes falsas de mujeres desnudas —y también de niñas— a partir de fotos reales de ellas vestidas. Del mismo modo que sucedió en aquel caso este bot ha sido entrenado solamente con imágenes femeninas, es decir que no se aplica a fotos de hombres.

Pero a diferencia de aquel emprendimiento denunciado y finalmente cerrado por su propio creador, que requería que los usuarios pagaran USD 50 para enviar una foto de una mujer y recibirla de regreso alterada digitalmente para verla desnuda, este instrumento para crear deepfakes disponible en varios canales de Telegram es gratuito. Como resultado, según el informe “Automatizando el abuso de imágenes”, de la firma de ciberseguridad Sensity AI, casi 105.000 mujeres, cuyas fotos fueron tomadas de sus cuentas en las redes sociales en un 70%, fueron objeto, sin saberlo, de la circulación pública de sus imágenes manipuladas.

Las cifras corresponden a julio de 2020 y hasta ese momento la cantidad de imágenes había crecido un 198% en tres meses, según el texto. “Una cantidad limitada de imágenes compartidas públicamente en los canales afiliados mostraban víctimas que parecían ser menores de edad”, agregó el análisis. “Por lo general son muchachas jóvenes,” dijo a MIT Technology Review Giorgio Patrini, director ejecutivo de Sensity AI y coautor del trabajo. “En algunos casos es bastante obvio que algunas de estas personas son menores de edad”.

De los más de 101.000 usuarios de esta herramienta en la app de mensajería Telegram, el 70% se hallaba en Rusia y otros países de la ex Unión Soviética, pero también había varios en Argentina, Italia y los Estados Unidos. “El bot recibió una importante publicidad mediante la red social rusa VK, que en sí misma albergó actividad asociada a él en unas 380 páginas”, según la firma especializada en detectar abusos de imágenes y videos manipulados.

La herramienta diseñada para alterar las imágenes de mujeres y violar su intimidad está conectada a siete canales de Telegram. El central, que tiene 45.000 miembros, alberga al bot en sí, mientras que los otros cumplen funciones de ayuda técnica o se utilizan para compartir las fotos. En el ultimo año, la comunidad —que se encuentra con mucha facilidad en las redes sociales y mediante los buscadores más populares— ha crecido de manera sostenida.

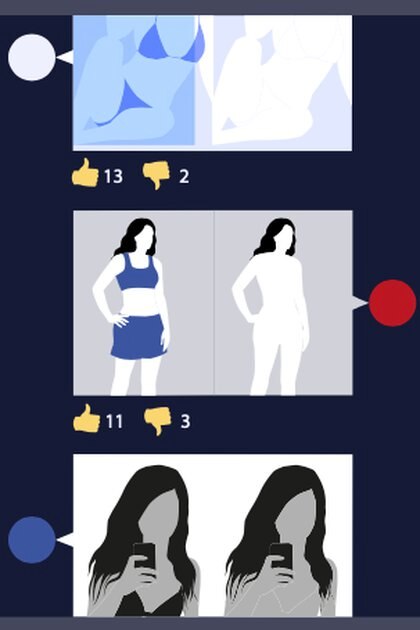

“Los canales de intercambio de imágenes incluyen interfaces que la gente puede utilizar para publicar y juzgar sus creaciones de desnudos. Cuantos más ‘me gusta’ obtiene una, más recompensa recibe su creador en fichas para acceder a las funciones premium del bot”, detalló MIT Technology Review. “El creador recibirá un incentivo como si estuviera jugando”, dijo Patrini a la publicación del Instituto de Tecnología de Massachusetts.

El caso DeepNude

En junio de 2019 el sitio Vice denunció que había una “aplicación horrible” que “desnuda la foto de cualquier mujer en un click”. El software utilizaba redes generativas antagónicas (GAN), algoritmos de inteligencia artificial en los que dos redes neuronales operan en competencia, famosos por ser los que generan las deepfakes. En menos de un día el escándalo fue tan grande que el creador de DeepNude la cerró y anunció que no continuarían con el producto.

“Hicimos este proyecto para el entretenimiento de los usuarios hace unos meses”, escribió sumergido en críticas, Alberto, el diseñador anónimo de DeepNude. “Nunca pensamos que se volvería viral y que no podríamos controlar el tráfico. Subestimamos, y mucho, la demanda. A pesar de las medidas de seguridad que adoptamos, si 500.000 usan la app, la probabilidad de que la gente la use maliciosamente es alta. No queremos ganar dinero de ese modo”.

No dio detalles, pero Katelyn Bowden, fundadora y CEO de la organización contra la pornovenganza Badass, resumió a Motherboard, parte de Vice: “Ahora cualquiera podría ser víctima de la pornovenganza, sin haber hecho nunca una foto desnuda. Esta tecnología no debería estar disponible para el público”. En la misma línea, Danielle Citron, profesora de derecho en la Universidad de Maryland, definió la actividad de la app para desnudar mujeres como una “invasión de la privacidad sexual”.

En el nuevo caso, los investigadores lograron identificar a algunas de las víctimas. Pero aunque las contactaron, no obtuvieron respuesta, dijo Patrini a MIT Technology Review. A continuación informaron a Telegram, en cuya plataforma opera el bot, y a las autoridades, entre otras a la Agencia de Investigaciones Federales (FBI). Según Haaretz —que estimó la cantidad de fotos manipuladas muy por encima de Sensity IA, en unas 600.000—, “Telegram cerró los grupos argumentando violación de sus términos de uso”.

Solo contra las mujeres

En diálogo con el medio israelí, Patrini señaló la violencia machista inherente a este caso: “Sólo las mujeres son blanco de este bot, no funciona con hombres. Basta con tener una cuenta en las redes sociales o compartir fotos en Instagram para ser un blanco si se es una mujer. Nadie está a salvo excepto que tengan altos niveles de seguridad en sus cuentas en redes, y ni siquiera así ya que los miembros de estos grupos dijeron que quieren desnudos de personas que conocen”.

En efecto, en una encuesta que los investigadores realizaron sobre 7.200 usuarios de estos canales de Telegram, el 63% dijo que quería desnudar sobre todo a “mujeres conocidas, a las que trató en la vida real”. Las demás elecciones de estas personas se ubicaron a mucha distancia: “Actrices, cantantes y otras celebridades”, 16%; “Modelos y bellezas de Instagram”, 8%; “Simplemente chicas de internet”, 7%. Sólo el 6% manifestó no tener interés en desnudar fotos de mujeres.

Según Haaretz, más del 95% de las imágenes y video manipulados que se encuentran en línea actualmente son pornografía, y de ellos casi la totalidad son deep nudes, que no se hacen al poner la cara de una persona en el cuerpo de otra sino que crean “imágenes sintéticas que tratan de respetar el tono de la piel, por ejemplo”, explicó Patrini.

La publicación del MIT agregó que hace ya bastante que esta tecnología se utiliza para acosar a las mujeres. “En 2019 un estudio de la Asociación Nacional de Psicología (APA) de los Estados Unidos halló que una de cada 12 mujeres sufre pornovenganza en algún momento de su vida. Un estudio del gobierno australiano, que analizó Australia, el Reino Unido y Nueva Zelanda, halló que la relación es de una de cada tres. Los deepfakes para pornovenganza le agregan una nueva dimensión al acoso, porque la víctima no sabe que tales imágenes existen”.

MÁS SOBRE ESTE TEMA:

Chats, blogs y subreddits: las leyes no frenan la difusión de fotos íntimas en redes sociales

El peligroso fenómeno de los deepfakes afecta principalmente a las mujeres, según un estudio

DeepNude: se dio de baja la polémica aplicación que “desnudaba” mujeres

[ad_2]

Source link